DeepSeek R1 в чем хайп?

MLPops / January 25, 2025

4 мин.

DeepSeek R1 — недавно выпущенная модель, которая возглавила рейтинги в нескольких ключевых областях. Вот некоторые из лидеров, которых она обошла:

- LiveBench: Второе место, уступая только GPT4 o1-2024-12-17 на момент написания.

- Aider: То же самое.

- Artificial Analysis: Пятое место, уступая только закрытым моделям Sonnet 3.5 и Gemini/OpenAI.

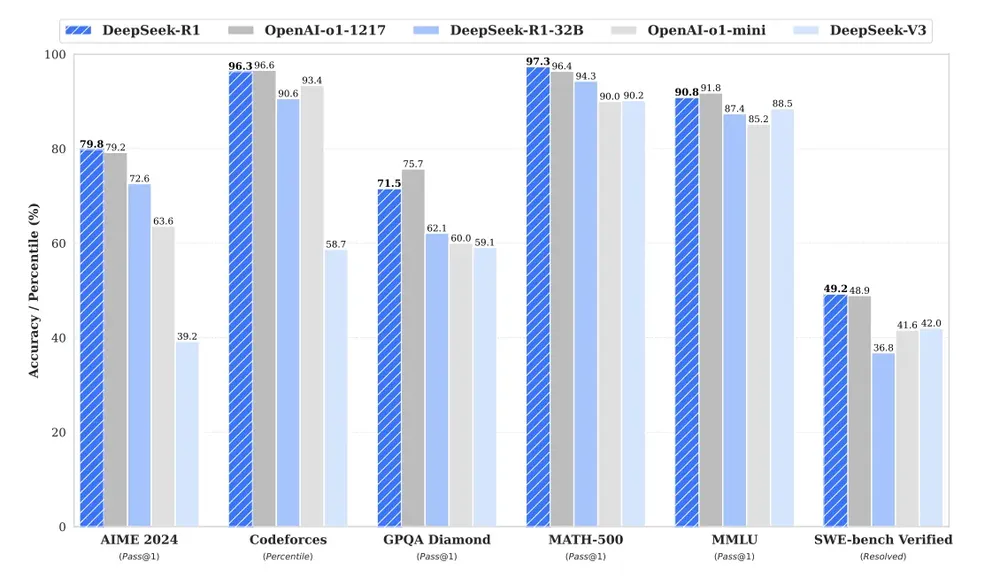

Кроме того, в статье о выпуске R1 показано, как она конкурирует с другими закрытыми моделями:

Наличие модели с открытым доступом к весам, которая способна конкурировать с лучшими закрытыми моделями, действительно вдохновляет.

Что делает R1 такой особенной?

Chain of Thought Prompting

Chain of thought prompting — это подход, который побуждает LLM разбивать процесс рассуждений на явные шаги, аналогично тому, как люди решают сложные задачи. Вместо того чтобы просто запрашивать ответ, мы направляем LLM «показать свои рассуждения», систематически продумывая проблему.

Есть ограничения на то, сколько информации можно загрузить в запрос для больших языковых моделей. Представьте каждую дополнительную задачу в запросе как дополнительный мяч для жонглера. Новичок (маленькая LLM) может удерживать в воздухе только два мяча и начнет их ронять при увеличении нагрузки. Даже лучшие жонглеры могут удерживать лишь ограниченное количество мячей. Чем больше задач вы даете LLM за один раз, тем выше вероятность того, что она упустит часть запроса или пожертвует одной задачей ради другой.

В отличие от этого, цепочка рассуждений позволяет жонглеру разделять движение каждого мяча без необходимости думать обо всех мячах одновременно. Движение рук — ключевой фактор поддержания жонглирования, а не размышления о траектории каждого мяча. Точно так же LLM с цепочкой рассуждений может зафиксировать предыдущий шаг логики и сосредоточиться на следующем.

Хотя Chain of Thought не является чем-то новым, уникальность R1 заключается в том, что вы можете извлекать эти рассуждения и отправлять их любой другой модели. Вы можете видеть отдельные шаги мышления модели. Научные исследования подтверждают повышение точности и качества работы LLM благодаря этому подходу. Однако до сих пор такие промежуточные шаги оставались скрытой областью закрытых моделей. R1 отличается тем, что прорабатывает каждый шаг по отдельности и позволяет наблюдать за процессом мышления практически в реальном времени.

By the way, you can extract JUST the reasoning from deepseek-reasoner, which means you can send that thinking process to any model you want before they answer you.

Like here where I turn gpt-3.5 turbo into an absolute genius! pic.twitter.com/vB1nd9xrJJ

— Pietro Schirano (@skirano) January 22, 2025

Пример запроса с цепочкой рассуждений:

A store is having a 20% off sale.

Sarah buys a shirt originally priced at $45 and pants originally priced at $65.

The store charges 8% sales tax on the final discounted price.

How much does Sarah pay in total?

Let's solve this step by step.

For each step, explain your thinking and show your calculations.Ответ может выглядеть так:

First, I'll calculate the discount on each item:

Shirt discount: $45 × 20% = $45 × 0.20 = $9

Pants discount: $65 × 20% = $65 × 0.20 = $13

Next, I'll find the discounted prices:

Discounted shirt price: $45 - $9 = $36

Discounted pants price: $65 - $13 = $52

Now I'll add the discounted prices together:

Subtotal after discount: $36 + $52 = $88

Finally, I'll calculate and add the sales tax:

Sales tax: $88 × 8% = $88 × 0.08 = $7.04

Total price: $88 + $7.04 = $95.04

Therefore, Sarah will pay $95.04 in total.Вы можете проверить тег deepseek_reasoning в формате JSON для просмотра внутреннего процесса мышления модели или вывести его явно.

Как начать работу с DeepSeek R1?

Дистилляции

Дистилляция — это процесс переноса знаний большой модели («учителя») в меньшую модель («ученика»). DeepSeek уже провела дистилляцию для нескольких популярных моделей:

deepseek-ai/DeepSeek-R1-Distill-Qwen-32Bdeepseek-ai/DeepSeek-R1-Distill-Qwen-1.5Bdeepseek-ai/DeepSeek-R1-Distill-Llama-7Bdeepseek-ai/DeepSeek-R1-Distill-Llama-8Bdeepseek-ai/DeepSeek-R1-Distill-Qwen-7Bdeepseek-ai/DeepSeek-R1-Distill-Llama-70B

Все эти модели можно запускать стандартным образом.

Квантования

Сообщество активно занимается квантованием R1. Например:

- GGUF-квантование от Unsloth позволяет запускать модель на H200 подах.

- Динамическое квантование снижает точность до 1.58 бит (вместо стандартных 4 бит), что позволяет запускать модель даже на двух A100 или H100.

Полные веса

Запуск R1 с полными весами требует распределенного вывода через несколько узлов (например, кластеров). Если вы планируете это сделать — свяжитесь с нами!

Заключение

R1 возвращает нас к захватывающей эпохе развития LLM! Она сочетает мощь закрытых моделей с доступностью открытого кода.

Вопросы? Присоединяйтесь к нашему Telegram каналу!